一、基本介绍:

基于VisualGLM 的快速安装服务。支持用户一键安装.

VisualGLM-6B是由语言模型ChatGLM-6B(ChatGLM-6B(ChatGLM-6B)详细信息 | 名称、简介、使用方法 | 数据学习 (DataLearner))与图像模型BLP2-Qformer结合而得到的一个多模态大模型,二者结合后的参数为78亿(62亿+16亿)。

VisualGLM-6B的特别之处在于它能够整合视觉和语言信息。可以用来理解图片,解析图片内容。

该模型依赖于CogView数据集中3000万个高质量的中文图像-文本对,以及3亿个精选的英文图像-文本对进行预训练。这种方法使视觉信息能够很好地与ChatGLM的语义空间对齐。在微调阶段,该模型在长视觉问答数据集上进行训练,以生成符合人类偏好的答案。

二:VisualGLM-6B模型的技术细节

VisualGLM-6B最令人兴奋的一个方面是其可访问性。由于集成了模型量化技术,用户可以在消费级显卡上本地部署模型,INT4量化级别只需要8.7G的显存。这意味着即使是拥有游戏笔记本的用户也可以快速且私密地部署这个模型,这在此类大小的ChatGPT-like模型中尚属首次。

VisualGLM-6B的运行硬件要求也还可以,FP16精度的模型需要15GB显存运行,而INT4量化版本需要8.7GB显存,比纯对话的ChatGLM-6B要求稍高。具体对比如下:

| 量化等级 | 最低 GPU显存(推理) | 最低 GPU 显存(高效参数微调) |

|---|---|---|

| FP16 (无量化) | 15 GB | / |

| INT4 | 8.7 GB | / |

三、VisualGLM的局限性

尽管VisualGLM-6B是一项重大的成就,但它仍处于v1版本,并且已知存在一些限制,例如图像描述中的事实/幻觉问题、对图像细节信息的捕捉不足,以及一些来自语言模型的限制。然而,这些问题预计将成为未来VisualGLM版本优化的重点。

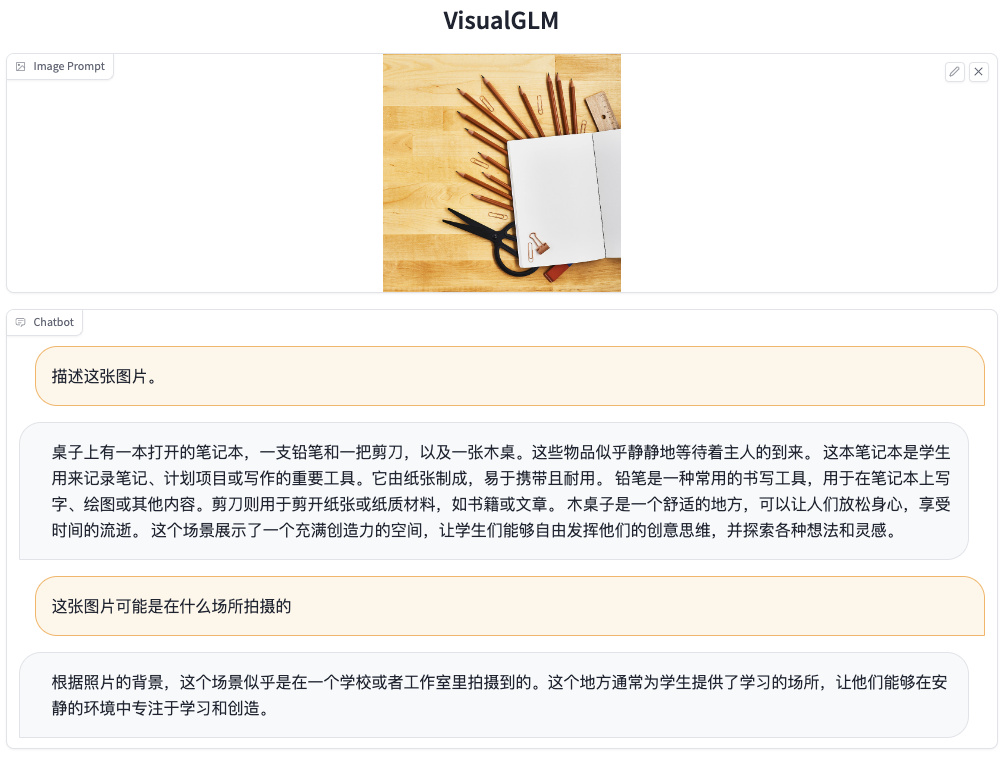

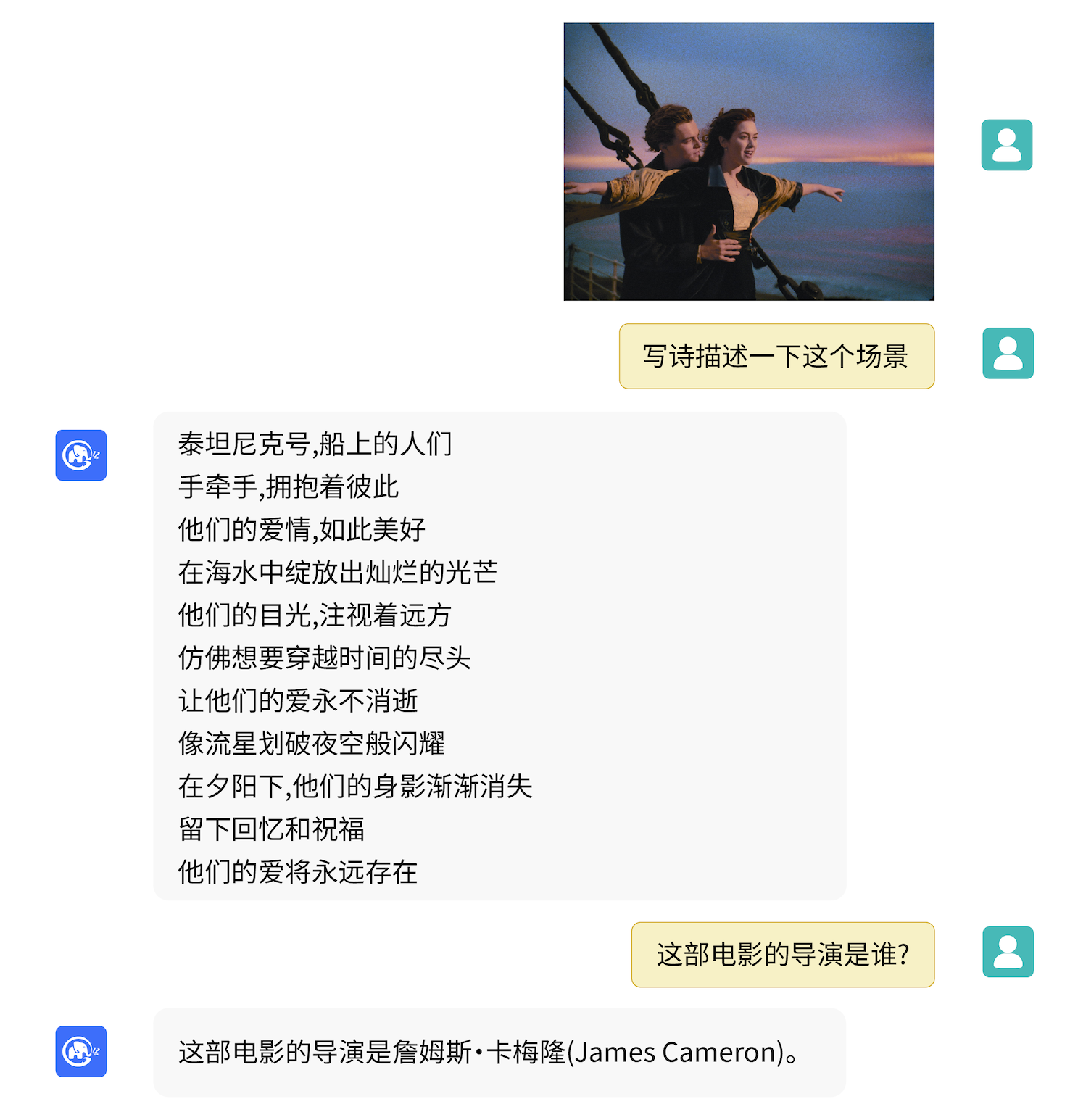

四、VisualGLM-6B模型的实际测试结果

根据测试,这个模型可以对输入的图片进行理解,但是对图片的文本内容理解不太好,也无法生成图片。

VisualGLM-6B模型的实际测试结果

官方在HuggingFace上部署了一套VisualGLM-6B的模型供大家测试。模型对图片的解析速度很快,问答返回结果也很不错。

五、VisualGLM安装使用方法:

1、硬件要求:

| 量化等级 | 最低 GPU品存(推理) | 最低 GPU 品存(高效参数微调) |

|---|---|---|

| FP16 (无量化) | 13 GB | 14 GB |

| INT8 | 8 GB | 9 GB |

| INT4 | 6 GB | 7 GB |

2、下载VisualGLM

百度网盘下载地址:百度云

链接:https://pan.baidu.com/s/1jH3JgYtGDZTDBcvQaP18Tw

提取码:jbai

3、一键运行

下载完成后,点击文件中的run.exe直接一键运行

运行完成后,即完成本地化VisualGLM安装,您可以直接进行使用。

请立即点击咨询我们,我们会详细为你一一解答你心中的疑难。点击立即沟通

在线QQ客服【点击对话】

在线QQ客服【点击对话】